智能讲解模块

智能讲解模块功能构成

智能讲解模块首要功能是实现精准的语音交互。在语音识别层面,支持多语种、多方言的语音输入,可对普通话、粤语、英语等不同语言,以及各地方言进行有效识别。对于不同语速、语调、口音的语音,通过动态时间规整(DTW)算法和声学模型优化,提升识别准确率。当用户发出语音指令,如 “介绍故宫太和殿”,模块能快速捕捉语音信号并转换为文本信息。同时,具备语音唤醒功能,在待机状态下,可通过特定关键词如 “你好,小助手” 激活模块,进入工作状态,降低系统能耗。

自然语言处理功能赋予模块语义理解与意图解析能力。基于深度学习的语义分析模型,如 Transformer 架构,可对输入的文本信息进行词法分析、句法分析和语义理解。不仅能理解字面含义,还能分析上下文语境、情感倾向,识别用户的潜在需求。当用户询问 “附近有什么好吃的川菜馆”,模块可解析出地点范围、菜系偏好等关键信息。结合知识图谱技术,将相关信息与庞大的知识库进行关联匹配,实现对复杂问题的准确理解,为后续信息检索与反馈提供基础。

信息检索与整合功能确保模块能快速获取准确答案。模块连接本地数据库和网络云端资源,构建多层次信息检索体系。本地数据库存储常用、固定的知识内容,如景区景点介绍、产品使用手册等,可实现快速本地检索;网络云端资源则用于获取实时、动态信息,如新闻资讯、天气情况、交通信息等。通过搜索引擎优化技术和高效的数据索引算法,在接收到用户问题后,迅速从海量信息中筛选出相关内容,并对检索到的信息进行整合、筛选、排序,去除冗余和无效信息,提炼出核心要点,为用户提供简洁、准确的回答。

语音合成与反馈功能将处理后的信息以自然流畅的语音形式输出。采用参数合成和波形拼接相结合的语音合成技术,模拟人类语音的韵律、语调、停顿等特征。通过调整基频、时长、共振峰等参数,使合成语音更接近真人发音,可根据不同应用场景和用户需求,设置多种语音风格,如亲切的女声、沉稳的男声、活泼的儿童声等。同时,支持语音播报的语速调节,用户可根据自身需求,在一定范围内调整语音播放速度,确保信息准确传达给用户。此外,在语音反馈过程中,可结合表情、动作(如在智能机器人应用中)等多模态信息,增强交互的生动性和趣味性。

智能讲解模块还具备学习与优化功能。通过机器学习算法,模块可对用户的提问模式、偏好、历史交互记录进行分析和学习。当用户多次询问某类问题时,模块可优化相关问题的回答策略和信息检索路径,提高回答的针对性和准确性。同时,利用用户反馈机制,当用户对回答不满意或提出修正意见时,模块将这些反馈信息作为训练数据,更新知识图谱和语义理解模型,不断提升自身的智能水平和服务质量。此外,支持远程固件升级和知识更新,开发人员可通过云端服务器向模块推送新的知识内容、算法优化程序,使其适应不断变化的用户需求和应用场景。

设计要点

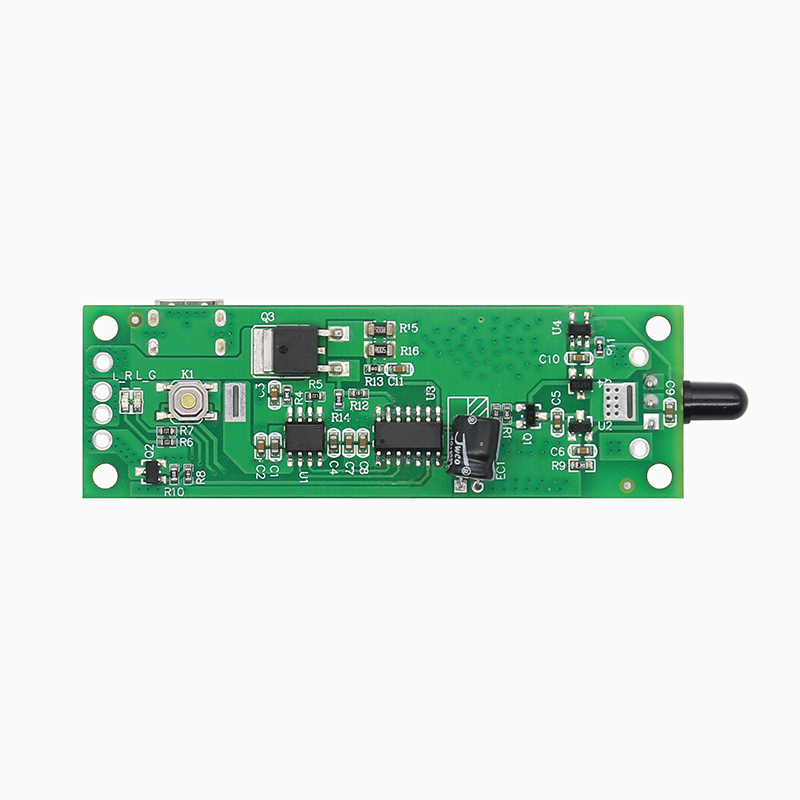

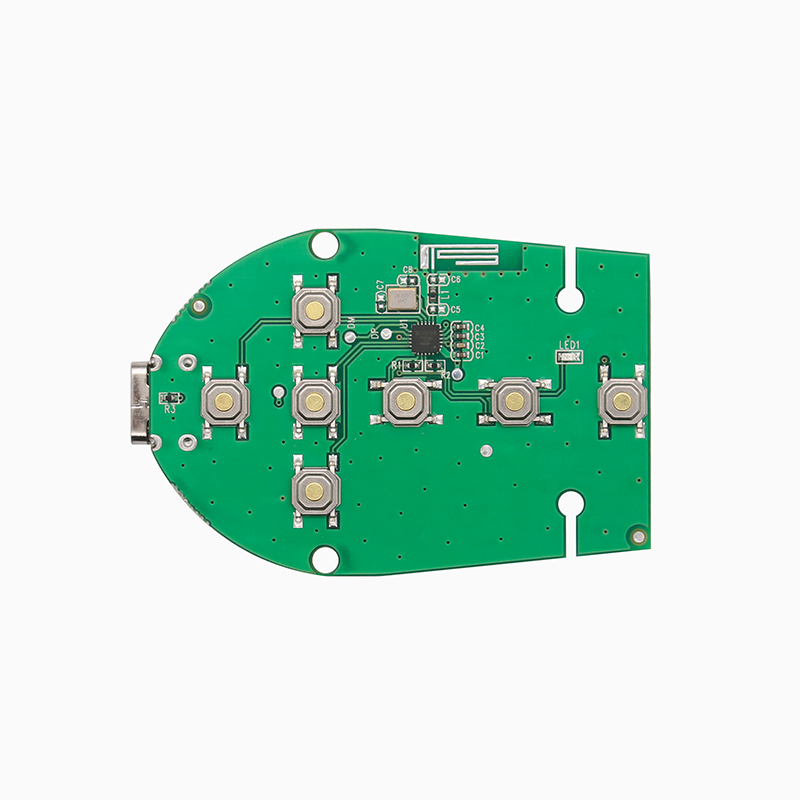

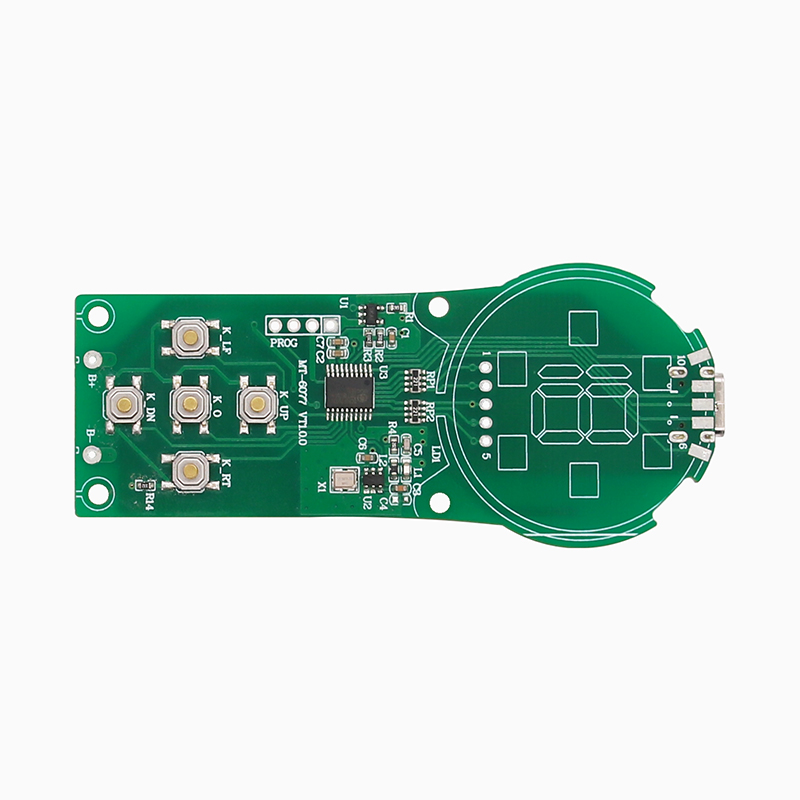

在硬件设计方面,需综合考虑性能、功耗和集成度。处理器选型至关重要,需具备强大的运算能力以支撑复杂的语音处理算法。采用多核异构处理器架构,将 CPU、GPU、NPU(神经网络处理单元)相结合,CPU 负责系统管理和常规任务调度,GPU 加速图形处理(在涉及可视化反馈场景),NPU 专门用于深度学习算法的加速计算,如语音识别和自然语言处理的模型推理,提高处理效率,降低响应时间。同时,合理规划电路板布局,将音频输入输出电路、处理器电路、存储电路等分区布局,减少信号干扰。采用多层 PCB 设计,优化电源层和地层的布线,降低电源噪声对信号的影响。对于音频输入输出接口,采用专业的音频编解码芯片和抗干扰电路设计,确保语音信号的高质量采集和输出。

软件架构设计需构建高效、灵活的系统框架。采用分层架构设计,从下至上分为硬件驱动层、操作系统层、中间件层和应用层。硬件驱动层负责与底层硬件设备进行交互,为上层软件提供统一的接口;操作系统层选择实时性强、稳定性高的嵌入式操作系统,如 Linux 嵌入式版或 RT - Thread,确保系统对语音信号的及时处理和任务调度;中间件层集成语音识别引擎、自然语言处理库、语音合成引擎等核心组件,提供标准化的接口供应用层调用;应用层根据具体应用场景开发相应的功能模块,如景区讲解应用、智能家居控制应用等。在软件开发过程中,采用模块化设计理念,将不同功能模块独立开发,便于后续的维护、升级和功能扩展。同时,注重软件的安全性设计,对用户数据进行加密存储和传输,防止数据泄露和恶意攻击。

算法优化是提升智能讲解模块性能的关键。在语音识别算法方面,采用端到端的深度学习模型,如基于注意力机制的 Transformer - ASR 模型,减少传统识别算法中特征提取和声学模型构建的中间环节,提高识别效率和准确率。通过增加训练数据量、优化模型结构和参数调整,提升模型对不同语音环境和口音的适应性。对于自然语言处理算法,利用预训练语言模型如 BERT、GPT 等,结合特定领域的语料进行微调,增强模型对专业知识和特定场景的理解能力。在信息检索算法中,引入基于深度学习的排序模型,如基于 BERT 的排序算法,根据用户问题和检索到的文档内容进行语义匹配,提高检索结果的相关性和准确性。此外,不断优化语音合成算法,通过改进参数合成技术和波形拼接算法,使合成语音更加自然流畅,减少人工合成的生硬感。

人机交互设计需充分考虑用户体验。在语音交互界面设计上,采用简洁明了的提示语和清晰的语音反馈逻辑,避免用户产生困惑。例如,在用户发出指令后,及时给予语音回应,告知用户已接收指令并正在处理。对于复杂问题或需要用户进一步确认的信息,采用分步骤引导的方式进行交互,如 “请问您是想了解该景点的历史背景,还是建筑特色?” 同时,结合图形界面(在具备显示屏的设备上)或灯光、振动等非语言反馈方式,增强交互的直观性和多样性。在交互流程设计上,优化从语音输入到语音输出的整个流程,减少用户等待时间,提高交互效率。通过用户测试和反馈,不断调整和优化人机交互设计,使智能讲解模块更加符合用户的使用习惯和心理预期。

系统集成与兼容性设计确保模块能在不同设备和平台上稳定运行。在硬件集成方面,设计标准化的接口协议,如 USB、I2C、SPI 等,方便与各类设备进行连接,如智能音箱、智能导游设备、智能家居中控系统等。在软件兼容性方面,开发多平台适配的软件版本,支持 Windows、Android、iOS 等主流操作系统,以及不同厂商的硬件设备。同时,遵循行业标准和规范,如语音识别的 ASR 标准、语音合成的 TTS 标准等,确保与其他相关系统和设备的互操作性。在系统集成过程中,进行全面的兼容性测试,包括不同网络环境、不同设备配置下的功能测试,及时发现并解决兼容性问题,保障智能讲解模块的广泛应用和稳定运行。

智能讲解模块组成元件

处理器芯片是智能讲解模块的核心运算单元,承担着语音处理、语义分析、信息检索等关键任务。采用多核处理器架构,如四核或八核处理器,具备较高的主频和强大的运算能力,能够快速处理大量的语音数据和执行复杂的算法。内置的 NPU 单元专门针对深度学习算法进行优化,可加速语音识别和自然语言处理模型的计算,大幅提升处理效率。同时,处理器芯片支持多种数据接口和通信协议,便于与其他元件进行数据传输和交互,如通过 SPI 接口连接存储芯片,通过 I2S 接口连接音频编解码芯片等,实现整个模块的高效运行。

存储元件用于存储模块运行所需的程序代码、数据模型和知识内容。包括闪存(Flash Memory)和随机存取存储器(RAM)。闪存用于存储操作系统、语音识别引擎、自然语言处理库、语音合成引擎等程序代码,以及知识图谱、用户历史交互记录等数据。采用大容量的闪存芯片,确保能够存储丰富的知识内容和不断更新的模型数据。RAM 则作为运行内存,为处理器提供临时的数据存储和运算空间,在语音处理过程中,用于存储待处理的语音数据、中间计算结果等。选择高速、低功耗的 RAM 芯片,保证数据的快速读写和系统的稳定运行,避免因内存不足或读写速度慢导致的系统卡顿和响应延迟。

音频编解码芯片负责语音信号的采集、处理和输出。在语音输入阶段,通过麦克风阵列采集模拟语音信号,音频编解码芯片将其转换为数字信号,并进行预处理,如降噪、增益调整、回声消除等,提高语音信号的质量。在语音输出阶段,将处理器处理后的数字语音信号转换为模拟信号,经过放大、滤波等处理后,驱动扬声器输出清晰、自然的语音。音频编解码芯片支持多种音频格式和采样率,如常见的 PCM、MP3 格式,以及 44.1kHz、48kHz 等采样率,可根据不同的应用场景和需求进行灵活配置。同时,具备低功耗、高保真的特点,确保在保证音频质量的前提下,降低模块的整体功耗。

通信模块实现智能讲解模块与外部设备或网络的连接,以便获取更多信息和实现远程控制。常见的通信模块包括蓝牙、Wi-Fi、4G/5G 等。蓝牙模块用于实现近距离的无线连接,如与手机、智能手表等设备配对,方便用户进行语音指令输入和接收语音反馈。Wi-Fi 模块支持高速的无线网络连接,使模块能够接入互联网,从云端服务器获取实时信息,如天气、新闻等,同时支持远程固件升级和数据同步。4G/5G 模块则提供更广泛的网络覆盖和更高的数据传输速率,适用于户外场景或对网络要求较高的应用,确保模块在各种网络环境下都能稳定、高效地工作。通信模块还具备安全加密功能,采用 WPA2、SSL/TLS 等加密协议,保障数据传输的安全性,防止信息泄露和非法访问。

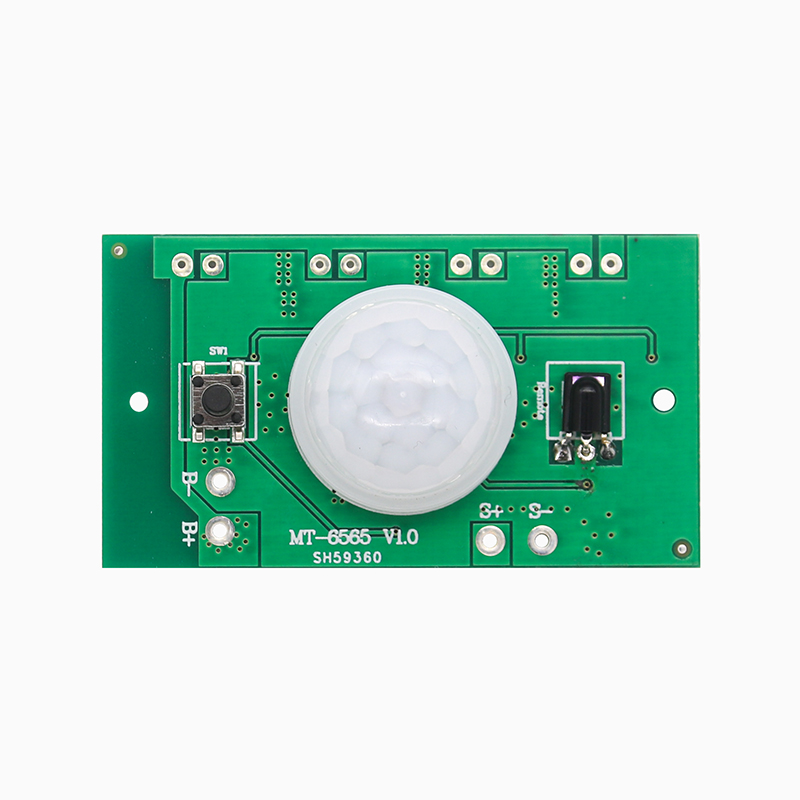

传感器元件为智能讲解模块提供环境感知能力,辅助提升交互体验和服务质量。麦克风阵列作为关键的音频传感器,通过多个麦克风的协同工作,实现声源定位、降噪和语音增强功能。能够准确捕捉用户的语音信号,同时抑制周围环境噪声的干扰,即使在嘈杂的环境中也能清晰采集语音。光线传感器可感知环境光线强度,在智能讲解设备的显示屏上自动调节屏幕亮度,提供舒适的视觉体验。距离传感器用于检测设备与用户之间的距离,当用户靠近时,自动唤醒设备或切换到更适合近距离交互的模式。此外,加速度传感器和陀螺仪可感知设备的运动状态和姿态,在智能导游设备中,根据设备的移动和转向,自动切换到相应景点的讲解内容,增强交互的智能化和趣味性。

智能讲解模块工作原理

当用户发出语音指令时,智能讲解模块开始工作。麦克风阵列采集到模拟语音信号后,传输至音频编解码芯片,将其转换为数字语音信号,并进行降噪、增益调整等预处理。处理后的数字语音信号通过 I2S 接口传输至处理器芯片,处理器芯片调用内置的语音识别引擎,基于深度学习模型,如基于 Transformer 的语音识别模型,将语音信号转换为文本信息。该模型通过对大量语音数据的训练,学习语音信号的声学特征和语言模型,能够准确识别不同口音、语速的语音内容。

识别后的文本信息进入自然语言处理环节。处理器芯片利用自然语言处理库和知识图谱,对文本进行词法分析、句法分析和语义理解,解析用户的意图和需求。例如,当用户询问 “附近的图书馆开放时间”,模块通过语义理解,提取出 “附近”“图书馆”“开放时间” 等关键信息,并结合知识图谱中关于地理位置、图书馆信息的关联数据,确定检索范围和条件。然后,根据这些信息在本地数据库和网络云端资源中进行信息检索,利用搜索引擎算法和数据索引技术,快速筛选出相关信息。

在信息检索过程中,若本地数据库无法满足需求,通信模块将通过 Wi-Fi 或 4G/5G 网络连接到云端服务器,获取更全面、实时的信息。检索到的信息返回处理器芯片后,进行整合、筛选和排序,去除冗余和无关内容,提炼出核心答案。接着,处理器芯片调用语音合成引擎,将文本答案转换为语音信号。语音合成引擎通过参数合成和波形拼接技术,模拟人类语音的韵律、语调等特征,生成自然流畅的语音。生成的数字语音信号再次传输至音频编解码芯片,转换为模拟信号后,驱动扬声器输出给用户。

- 2025-06-25

- 2025-06-25

- 2025-06-25

- 2025-06-25

- 2025-06-25

- 2025-06-24

- 2025-06-24

- 2025-06-24

- 2025-06-24

- 2025-06-24

- 2025-06-23

- 2025-06-23

- 2025-06-23

- 2025-06-23

- 2025-06-23

- 2025-06-21

- 2025-06-21

- 2025-06-21

- 2025-06-21

- 2025-06-21

- 2025-06-19

- 2025-06-19

- 2025-06-19

- 2025-06-19

- 2025-06-19